ビジネスの変化に応じてAIを活用し続けるには、機械学習の運用の効率化が必要です。それには、機械学習のライフサイクルを管理するためのMLOpsの導入が効果的です。

AWS SageMakerを使ったMLOpsの構築、AWSの豊富なサービスの中から最適なものを選択しAIの運用を内製化するご支援をします。

MLOpsが注目される理由と新たな課題

近年、AIを活用したサービスが増えていますが、AIサービスの開発には様々な問題が立ちはだかります。

- 入力データが変動することで、モデル精度が低下する

- 実験環境で達成できていたモデルの精度が、本番環境では再現できない

- チームが複数の専門家(AI開発担当者やシステム開発担当者等)によって編成されるため、引き継ぎのコミュニケーションに手間がかかり、サービス開発・運用に全体の時間が増大する

そこで、MLOpsという、機械学習チーム、システム開発チームと運用チームが各々協調し合うことで、機械学習モデルの実装、本番システムへの適用、運用までのプロセスを円滑に実行することができる手法および考え方が注目されています。MLOpsを導入すると、AIサービス開発および運用の効率化が図られ、上記の問題を解決することが可能となります。

MLOpsの導入には、データサイエンススキルとシステム開発スキルの両方が求められるため、自社のみではハードルが高いのが実情です。そこで、MLOps導入支援経験があり、様々な企業様のビジネスにAIを適用・活用してきた豆蔵がお客さまへのMLOps導入をお手伝いいたします。

実現イメージ

MLOpsを実践するには、それを支えるシステム基盤と運用ルールの整備が不可欠です。

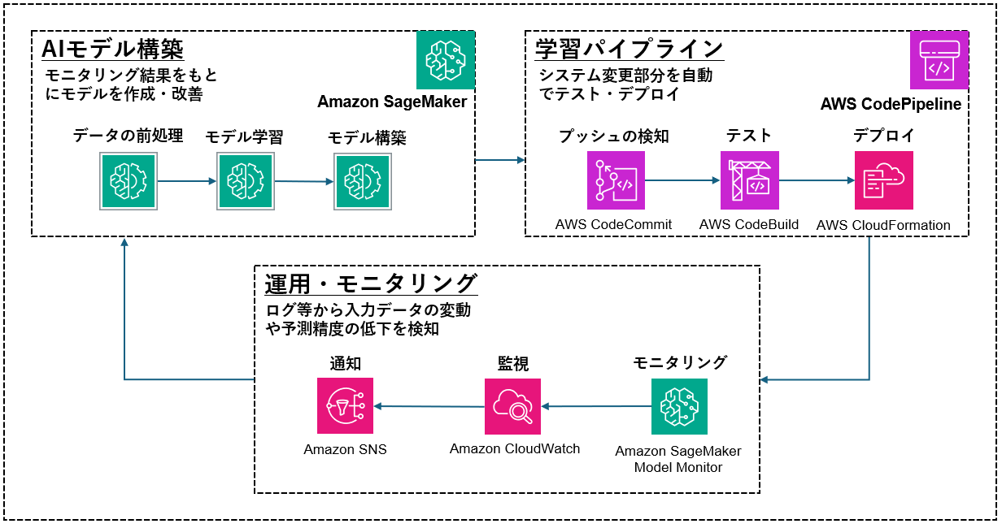

AIモデルを作成・改善する環境、作成したモデルを自動でデプロイする仕組み、運用時に結果をモニタリングし変動を検知する仕組み、これらを1つのクラウド上に構築し、シームレスに実行できるようにします。

- MLOpsデータ解析基盤イメージ

構築例では、Amazon SageMakerを活用したAIモデル構築、AWS CodeCommit、AWS CodeBuild、AWS CloudFormationを用いた自動デプロイ、さらにAmazon CloudWatch、Amazon SageMaker Model Monitor 、Amazon SNSで運用とモニタリングを自動化しています。

- AIモデル構築を含むライフライクルの自動化

分析者が作成したAIモデルを開発者がシステムに組み込むと自動でテスト・デプロイ、予測結果をもとに分析者がモデルを作成する、というライフサイクルを実現します。 - 学習パイプラインによる効率化

管理されたモデルとパイプラインにより、実験環境の再現性を確保し、本番環境でも同じ精度で発揮できるようにします。

また、リリース、ログ出力および監視結果通知のプロセスをパイプラインを設けて自動化することにより、専門家間の担当引継ぎをスムーズにし、各々のタスクに集中できるようにします。 - 運転・モニタリングによる、AIモデルの劣化の防止

入力データの変動やモデル精度のモニタリングをクラウド基盤に組み込むことで、変化を迅速に把握しモデルの修正に着手できます。

進め方

- STEP1:課題とゴールの明確化

現在の学習プロセスや運用における顕在化した課題をヒアリングを通して明確にします。

モデルの構築からリリースまでのリードタイムや運用と構築のチーム間でのやり取りなどの潜在的な課題を調査し明確化します。

これらの調査から問題の原因を洗い出し、MLOpsの導入による改善効果が高い領域を特定します。 - STEP2:解決策のご提案

明確になった課題を元にお客さまのシステム環境に応じた解決策をご提案いたします。

MLOps実装ステップの設計や最適なCI/CDツールの導入、伴走型の実装支援等様々な提案が可能です。 - STEP3:継続的なご支援

MLOpsの導入後の運用フェーズも継続的にご支援を行う事で確実な内製化を支援いたします。

モデル更新の頻度やモデル比較手法の選定など、運用フェーズでよく発生する課題を解決しながら、お客さま自身が運用を行えるようスキルトランスファーを実施いたします。

豆蔵の強み

- データサイエンスとシステム開発の両分野のスキルをワンチームで提供

数理科学系・計算機科学系の博士号などの学位を有するデータサイエンティストとシステム開発経験の豊富なコンサルタント・エンジニアをメンバーに揃えています。 - AWS、 Azure等、様々なクラウド基盤に対応可能

- DXの支援、AI/MLOps導入の豊富な実績